| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | |||

| 5 | 6 | 7 | 8 | 9 | 10 | 11 |

| 12 | 13 | 14 | 15 | 16 | 17 | 18 |

| 19 | 20 | 21 | 22 | 23 | 24 | 25 |

| 26 | 27 | 28 | 29 | 30 | 31 |

Tags

- Meta Pseudo Labels

- 컴퓨터구조

- BYOL

- ConMatch

- adamatch paper

- UnderstandingDeepLearning

- remixmatch paper

- 최린컴퓨터구조

- mocov3

- cifar100-c

- CoMatch

- Pseudo Label

- CycleGAN

- GAN

- 딥러닝손실함수

- shrinkmatch

- semi supervised learnin 가정

- dann paper

- mme paper

- CGAN

- SSL

- dcgan

- conjugate pseudo label paper

- simclrv2

- tent paper

- 백준 알고리즘

- shrinkmatch paper

- Entropy Minimization

- Pix2Pix

- WGAN

Archives

- Today

- Total

Hello Computer Vision

lr_scheduler CosineAnnealingLR 알아보기 본문

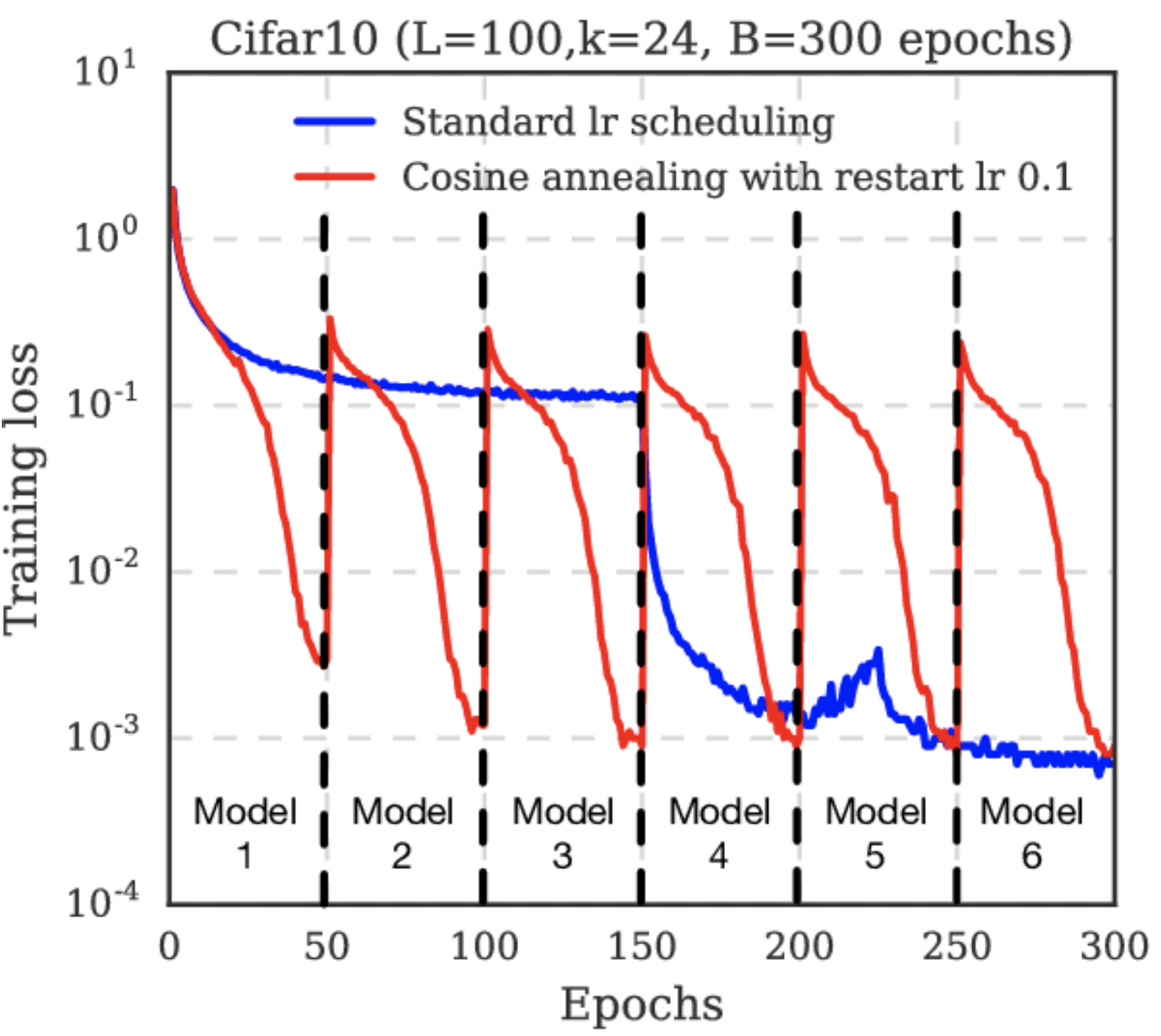

BYOL 논문 설명을 보다 해당 학습 스케쥴러에 대한 내용이 보여 한번 알아보려고 한다. 학습률을 관리하는 기법도 참 많은 거 같은데 이것만 관리해서 과연 얼마나 정확도가 올라갈지 직접 보지는 않아서 모르겠다

해당 공식 문서

https://pytorch.org/docs/stable/generated/torch.optim.lr_scheduler.CosineAnnealingLR.html

CosineAnnealingLR — PyTorch 2.0 documentation

Shortcuts

pytorch.org

우선 식은 다음과 같다. 우선 기본적으로 코사인 함수 주기함수를 따른다.

min, max가 들어가있는 기호는 직접 지정해주는 학습률 최대,최소값이다.

Tcur : 현재 몇번째 epoch인지

Tmax: 주기 최대 epoch

그림을 살펴보면 지정한 max epoch마다 학습률이 주기적으로 증가하고 감소하는 것을 확인할 수 있다.

Reference

https://paperswithcode.com/method/cosine-annealing

'딥러닝 > 파이토치' 카테고리의 다른 글

| pretrained 모델에 fc레이어 추가해보기 (0) | 2023.05.14 |

|---|---|

| F.cross entropy 구현 및 설명해보기 (0) | 2023.05.12 |

| argmax의 keepdim = True, False (0) | 2023.05.01 |

| 코사인 유사도(Cosine Similarity) 알아보기 (0) | 2023.03.29 |

| [pytorch] transpose, view 의 차이 알아보기 (0) | 2023.03.16 |