| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- tent paper

- semi supervised learnin 가정

- adamatch paper

- mocov3

- conjugate pseudo label paper

- CycleGAN

- shrinkmatch

- 딥러닝손실함수

- WGAN

- cifar100-c

- mme paper

- SSL

- 최린컴퓨터구조

- dcgan

- simclrv2

- Pix2Pix

- BYOL

- dann paper

- 컴퓨터구조

- ConMatch

- UnderstandingDeepLearning

- Entropy Minimization

- CGAN

- CoMatch

- Pseudo Label

- remixmatch paper

- 백준 알고리즘

- GAN

- Meta Pseudo Labels

- shrinkmatch paper

- Today

- Total

Hello Data

비전공생의 Extremely Simple Activation Shaping for Out-of-Distribution detection2023 본문

비전공생의 Extremely Simple Activation Shaping for Out-of-Distribution detection2023

지웅쓰 2023. 12. 17. 15:44ICLR 2022에 억셉된 논문이고 굉장히 간단한 테크닉을 사용한다. 저자는 해당 방법을 ASHActivationSHaping라고 한다.

https://openreview.net/pdf?id=ndYXTEL6cZz

Introduction

이전의 딥러닝 모델들 같은 경우 어떤 것이 더 좋은 방법인지 training 과정을 반복했다. 그러나 모델이 점점 커지면서 이러한 방법은 힘들어짐에 따라 별다른 training 과정 없이 model의 성능을 올리는 post hoc방법이 각광받고 있다고 한다뭔가감은오는데정확히는잘모르겠다. OOD detection문제의 경우 이 질문 하나로 정의될 수 있다.

"Do models know when they don't know?"

많은 노력에 따라 OOD detection은 발전해왔으나 OOD detection 과 ID accuracy 에는 trade-off가 있다고 한다. 이상적으로는 OOD detection이 분류성능에 영향을 미치지 않는 것이 좋다고 한다. 이 논문과 비슷한 논문을 말하라고 하면은 ReAct, DICE를 저자가 언급한다. ReAct는 score function을 적용하기 전 feature representation 에 대하여 percentile 에 대한 threshold를 적용해 중요하지 않은 feature를 닫는다고 할 수 있다. 이 논문 역시 유사하게 진행된다. 프레임워크는 다음과 같다.

pre-trained model에 대해 나온 representation 에 대해 simplified representation을 따로 산출하고 이를 사용하는 것을 확인할 수 있다. 이 논문의 key contributionㅇ은 다음과 같다.

1. We propose an extremely simple, post-hoc and one-shot activation reshaping method, ASH, as a unified framework for both the original task and OOD detection

2. When evaluated across a suite of vision tasks including 3 ID datasets and 10 OOD datasets Table1, ASH immediately improves OOD detection performances across the board, establishing a new state of the art SOTA, meanwhile providing the optimal ID-OOD trade-off, supplying a new Pareto frontier

3. We present extensive ablation studies on different design choices, including placements, pruning strength, and shaping treatments of ASH, while demonstrating how ASH can be readily combined with other methods, revealing the unexpected effectiveness and flexibility of such a simple operation

The Out-of-distribution detection setup

1. ID 데이터들로 먼저 모델을 train 후, model의 파라미터를 freeze한다.

2. Inference 시에는 OOD데이터를 사용한다.

3. Inference 시에 detector에 모델을 사용하며 해당 부분에서 score function을 사용한다detector는따로layer를사용하는것이아니라model의output에대하여score를제시하는부분이라고할수있다.

4. evalutation metric을 통해 평가한다.

여기서 하나 눈여겨볼점은 ReAct처럼 분류할 때의 framework를 크게 벗어나지 않는다. 단순히 model의 output에 대한 post hoc을 통해 OOD를 찾아내는 것이다.

detection score같은 경우 여러개를 제시할 수 있지만 softmax, energy function을 사용하며 비교한다.

Activation Shaping for OOD detection

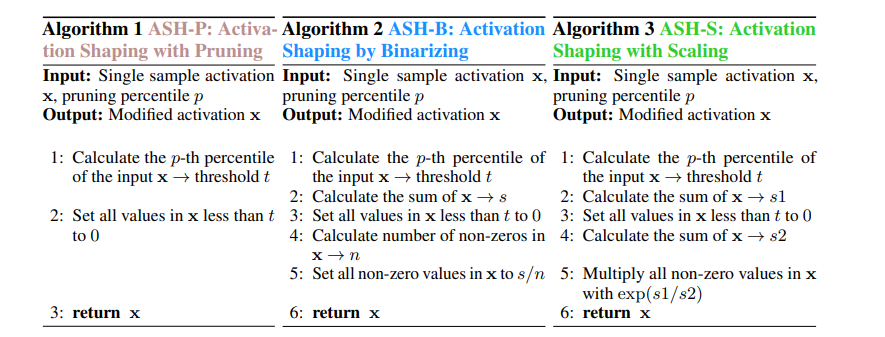

본격적으로 어떻게 pruning 했는지가 관건인데 총 3가지 방법을 소개한다.

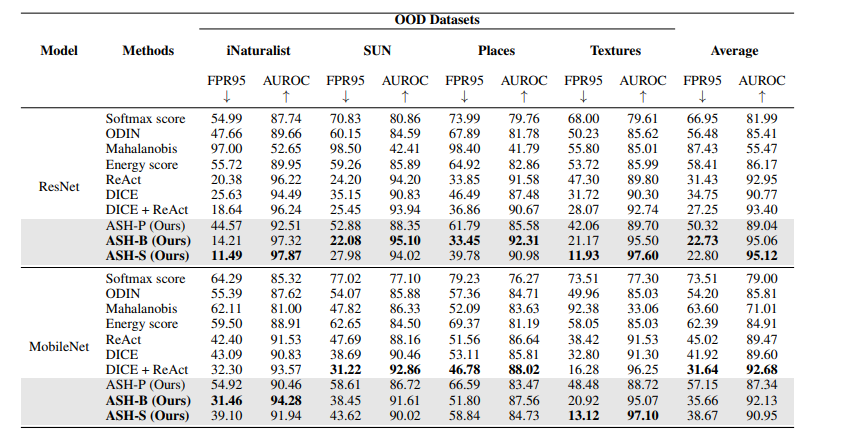

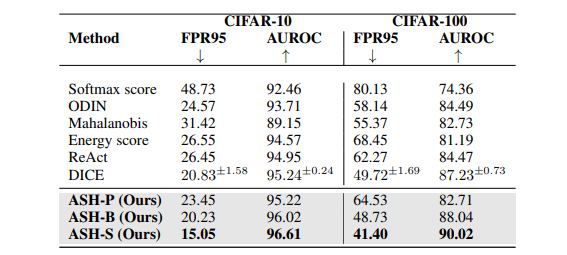

알고리즘 3개와 figure를 비교해보면 어떤 것을 사용하든 다른 방법보다 성능이 좋은 것을 알 수 있으며 가장 좋은 것은 알고리즘3이라고 할 수 있다.

또 ReAct와 다른 점을 언급한 점은 ReAct 같은 경우 training 데이터에 대해 요약한 threshold를 사용했다면 여기서는 각 데이터 x에 대한 feature 에 대해 threshold를 사용하는 것이 큰 차이점이다.

Result

ASH는 분류와 OOD 분류간의 trade-off 가 가장 효율적이었다고 말한다.

Ablation Studies

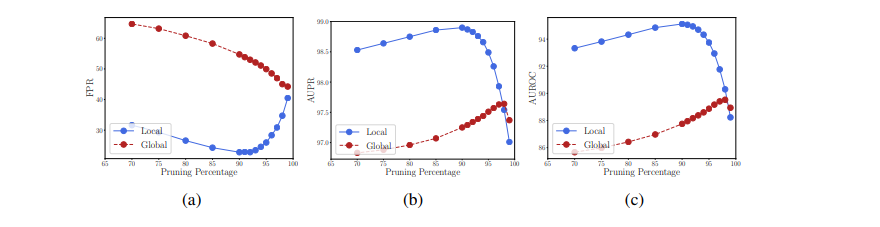

주목해볼점은 ReAct와 다르게 사용한 threshold방식이다. ReAct는 좀 더 global한 threshold라면 ASH는 local 한 threshold라고 할 수 있다.

figure를 본다면 local한 정보를 활용하는 것이 훨씬 좋았다고 한다. 그러나 단점으로는 slight computational overhead가 있다고 한다.